你好!!我是Palind,这里是我的博客~

You’re very welcome to check out my blog!

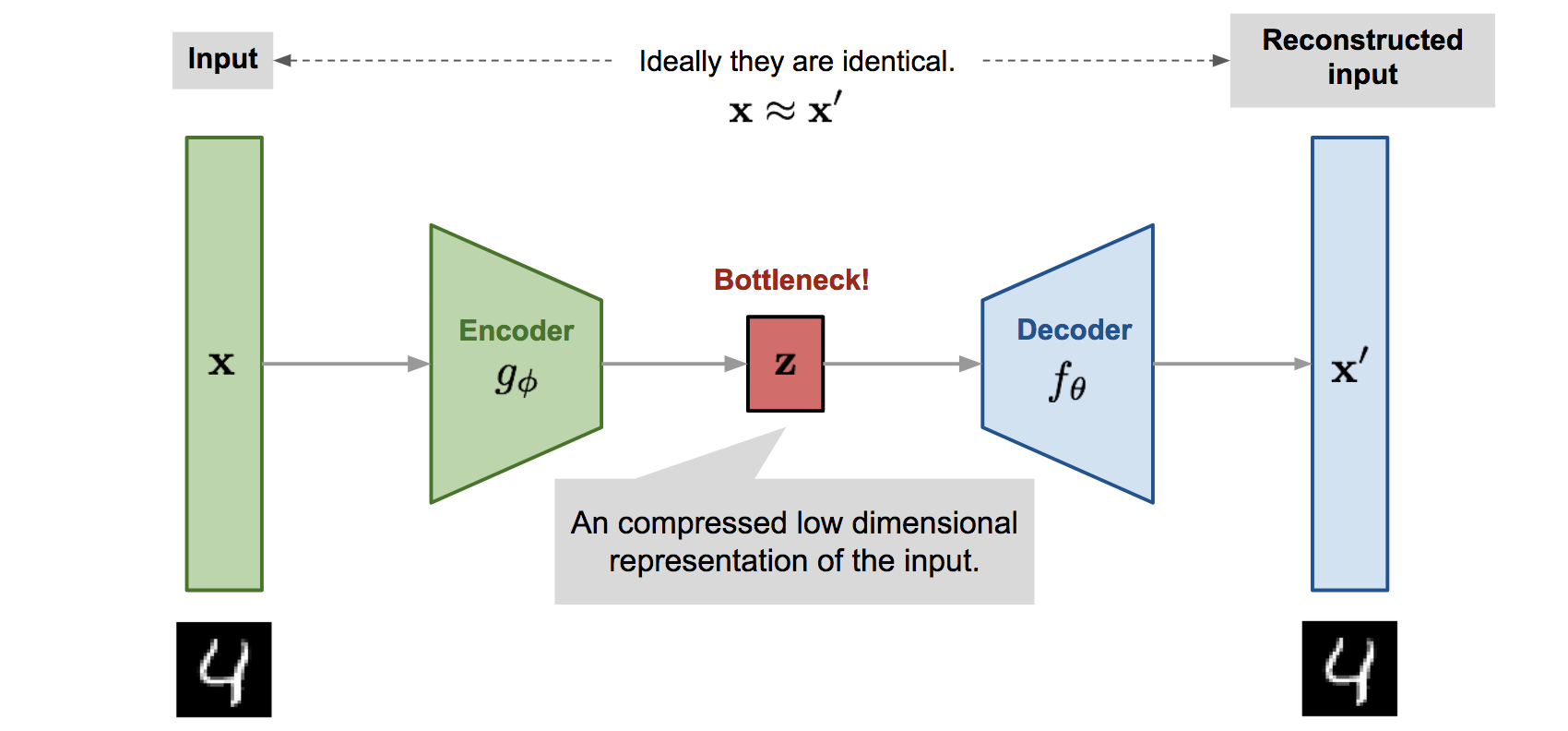

我对 ML 很感兴趣,正在学习 PyTorch🔥和一些经典的论文📃。

你想看看我最近写的博客嘛?我建议你来看看以下这些,很好玩的!

🚀 Flow Matching学习笔记 对 Flow Matching 的学习

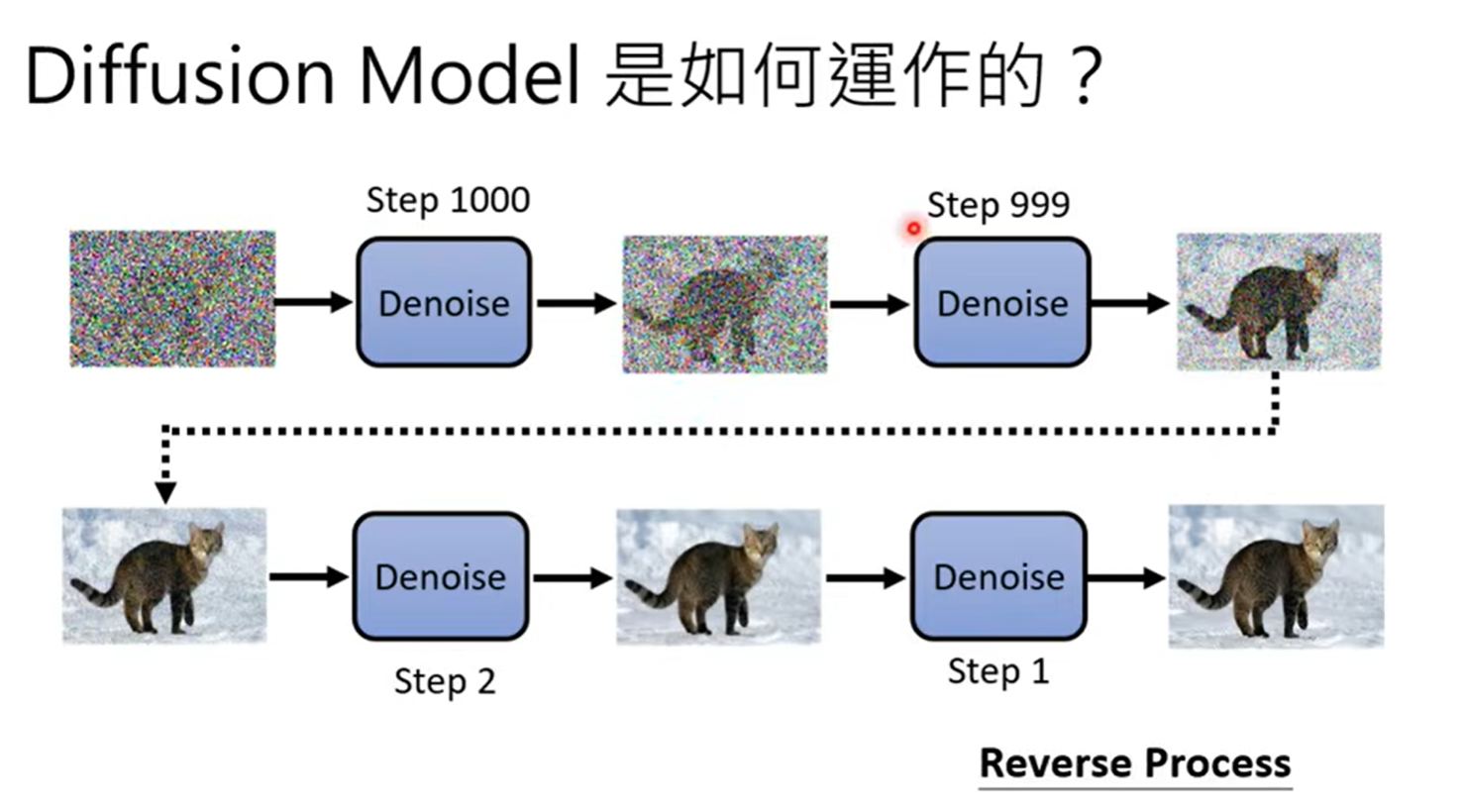

🔥 Diffusion Model学习笔记 对 DDPM 的学习

🌸 ViT论文复现笔记 对 ViT 的代码复现

……我还写了一些札记记录生活,在此就不一一列举啦。